Imagina que cada equipo de tu empresa fuera una banda de música.

Ventas con sus cifras, marketing con sus leads, operaciones con sus tiempos y logística con su inventario.

Todos tocando al mismo tiempo… pero sin partitura común.

¿El resultado? Ruido. Muchos datos, poca música.

Aquí es donde entra el Data Warehouse.

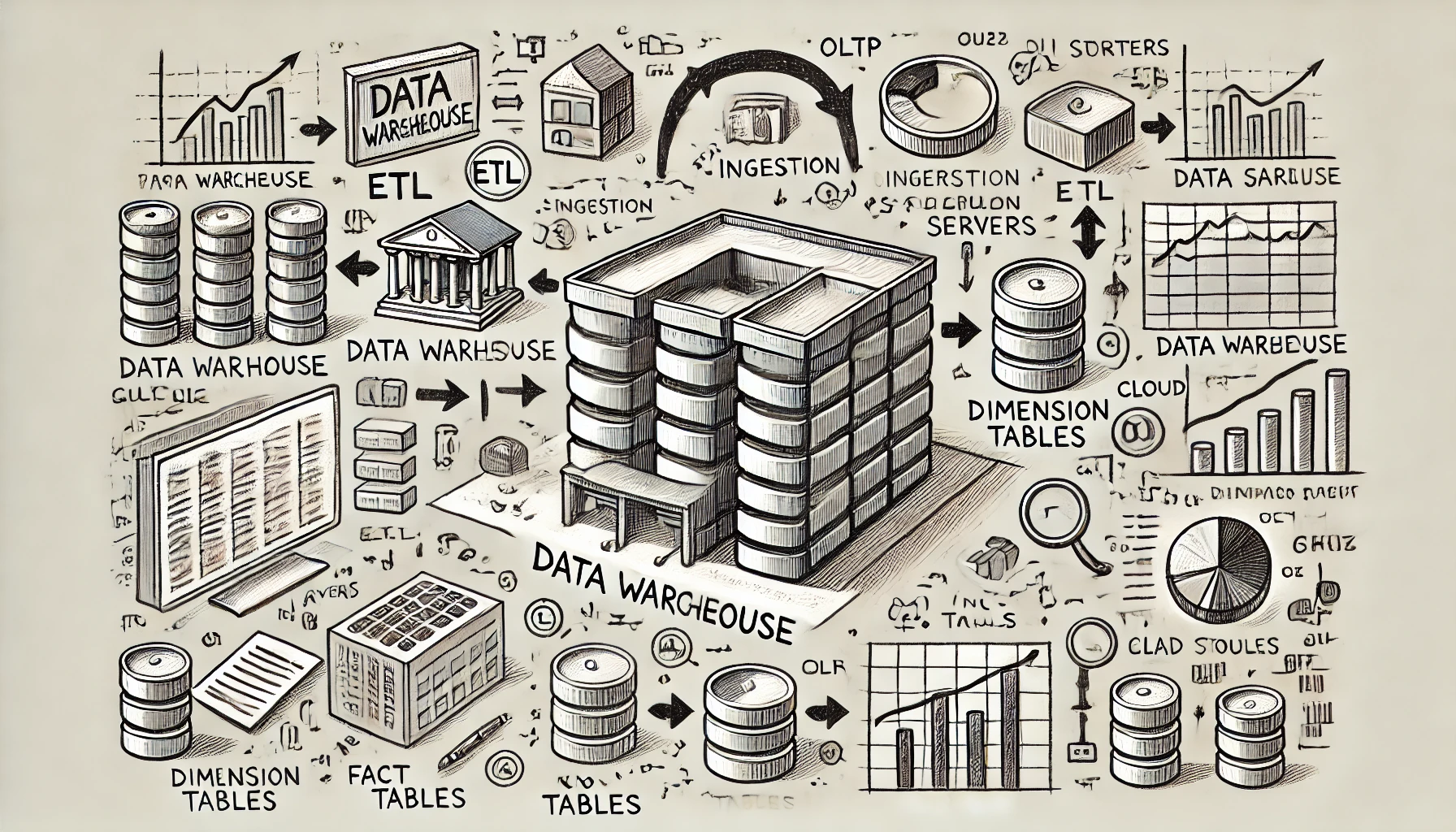

Qué es un Data Warehouse

Un Data Warehouse (o almacén de datos) es una plataforma diseñada para almacenar, organizar y analizar grandes volúmenes de información proveniente de diferentes sistemas de tu empresa.

A diferencia de las bases de datos operacionales que se enfocan en el día a día, un Data Warehouse está pensado para responder preguntas clave sobre tu negocio.

No es solo dónde guardas los datos.

Es cómo los preparas para analizarlos, cruzarlos y convertirlos en decisiones.

Por eso se convierte en el centro neurálgico de cualquier estrategia de análisis avanzada.

Además, el Data Warehouse es la puerta de entrada al Big Data.

Si tu empresa está creciendo y empiezas a trabajar con millones de registros, flujos en tiempo real o datos no estructurados, esta infraestructura te prepara para escalar y aprovechar tecnologías como inteligencia artificial o machine learning.

El corazón de tu estrategia de datos

Un Data Warehouse es como ese gran escenario donde todas las bandas se sincronizan.

Una base de datos centralizada, pensada para analizar, no para operar.

Reúne información de múltiples fuentes: ERP, CRM, hojas de cálculo, APIs… y la estructura para que sea fácil consultar y tomar decisiones.

«Un buen Data Warehouse no guarda datos: te da respuestas.»

¿Por qué no basta con tus dashboards?

Porque tus dashboards son el escaparate.

Pero si los datos vienen desordenados, duplicados o con retraso, mostrarán una versión distorsionada de la realidad.

Un Data Warehouse te permite:

- Unificar datos de distintas fuentes (sin depender del Excel de Paco)

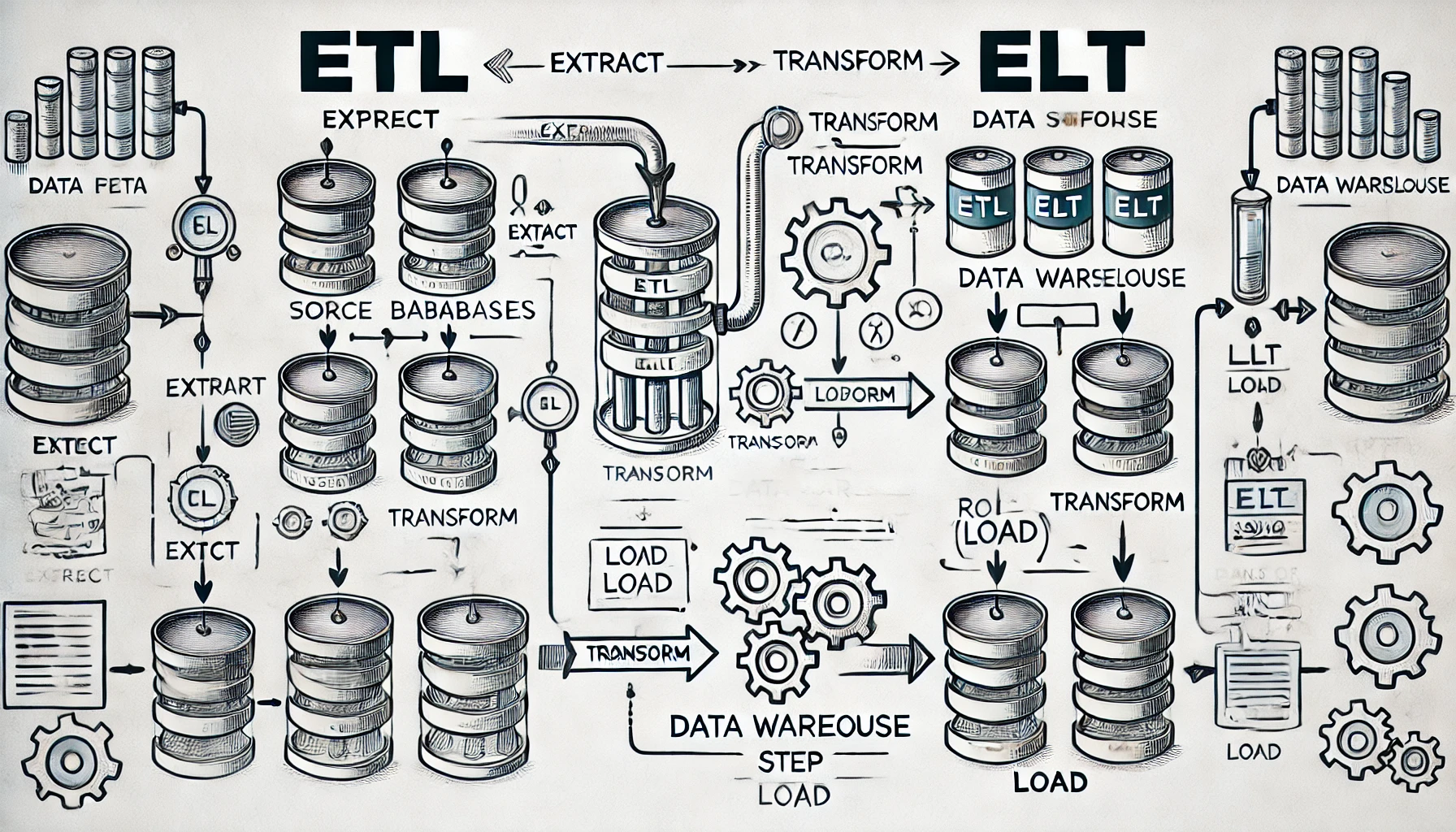

- Automatizar procesos de carga, limpieza y transformación

- Escalar tus análisis sin reinventar la rueda cada semana

- Asegurar calidad y trazabilidad en tus informes

Mini-caso: de caos a control

Una startup de ecommerce tenía datos por todas partes: Shopify, Google Ads, Sheets, Mailchimp…

El equipo de marketing tardaba 3 días al mes en preparar un reporte decente.

Montaron un Data Warehouse con Google BigQuery y Looker Studio.

Resultado: reportes listos en minutos, sin errores, con alertas automáticas.

Casos reales: cómo empresas aprovechan Google BigQuery

1. Cabify: optimización del análisis de datos en tiempo real

La empresa de movilidad Cabify integró Google BigQuery en su infraestructura para procesar grandes volúmenes de datos generados por sus operaciones en múltiples ciudades.

Esta implementación permitió a sus equipos de datos acceder a información más actualizada y reducir la carga operativa, facilitando decisiones más ágiles y eficientes.

2. BQ: escalabilidad y reducción de costos en electrónica de consumo

La compañía tecnológica BQ adoptó Google BigQuery junto con otras herramientas de Google Cloud para mejorar sus servicios y reducir costos.

Gracias a esta estrategia, lograron escalar sus servicios de manera eficiente, proporcionando mejor atención al cliente y acelerando su tiempo de comercialización.

3. Millennium BCP: impulso en conversiones digitales

El banco portugués Millennium BCP utilizó Google BigQuery para analizar datos de sus esfuerzos de ventas digitales, logrando aumentar sus tasas de conversión en un 2.6 veces.

Esta mejora significativa en sus operaciones digitales demuestra el poder de Google BigQuery en el sector financiero.

4. Comercio electrónico del Reino Unido: análisis avanzado de clientes

Una tienda online migró sus datos de Shopify y Google Analytics a Google BigQuery para realizar análisis más avanzados.

Esta migración les permitió obtener insights más profundos sobre el valor de vida del cliente y la retención, optimizando sus estrategias de marketing y ventas.

5. Fabricante global de cosmética: análisis 5 veces más rápido

Un fabricante global de productos para el cuidado de la piel migró su infraestructura de análisis a Google BigQuery, logrando análisis más profundos y precisos cinco veces más rápido que antes.

Esta mejora permitió decisiones más informadas y oportunas en sus estrategias de negocio.

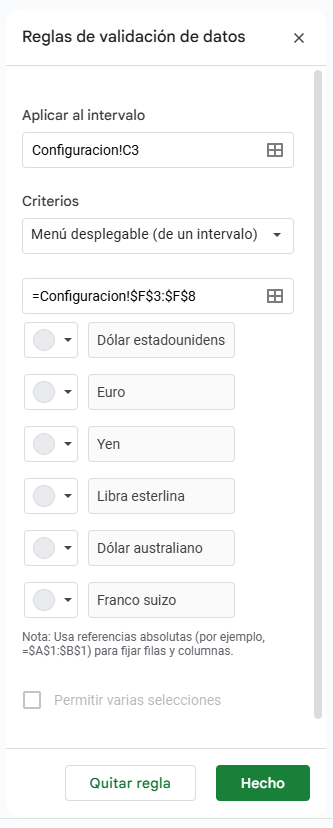

¿Cómo elegir la mejor plataforma?

Antes de lanzarte a implementar, responde estas preguntas:

- ¿Tu equipo ya trabaja con Google Workspace? Google BigQuery será un aliado natural.

- ¿Usas AWS para otros servicios? Redshift integrará mejor con tu ecosistema.

- ¿Necesitas máxima flexibilidad y rendimiento multi-nube? Snowflake puede ser tu opción.

- ¿Tu empresa depende de Microsoft? Synapse funciona perfecto con Power BI y Excel.

- ¿Buscas una opción low-cost con control total? PostgreSQL + dbt es ideal para entornos técnicos con recursos limitados.

👉 Consejo: empieza por una necesidad concreta (un reporte clave, una integración crítica) y crece desde ahí. No intentes resolverlo todo de golpe.

Comparativa de plataformas: ¿por qué elegir Google BigQuery?

| Plataforma | Ventajas principales | Ideal para… |

|---|---|---|

| Google BigQuery | Escalable, sin mantenimiento, precios por consulta, integración nativa con Looker, potente para Big Data y Machine Learning | Empresas con Google Workspace, análisis ágil |

| Amazon Redshift | Integración nativa con AWS, rendimiento sólido en cargas masivas | Usuarios del ecosistema AWS |

| Snowflake | Multi-nube, rendimiento alto, escalado automático, pago por uso | Equipos que buscan flexibilidad total |

| Azure Synapse | Integración con Power BI, Excel y Dynamics 365, buena opción híbrida | Empresas con stack Microsoft |

| PostgreSQL + dbt | Bajo coste, control total, comunidad activa | Proyectos personalizados o con bajo presupuesto |

Como has visto, Google BigQuery es una apuesta segura para empresas que necesitan escalar rápido y con precisión.

Pero no es la única.

Dependiendo de tu volumen de datos, presupuesto y conocimientos técnicos, hay otras plataformas igual de potentes que podrían adaptarse mejor a tu caso.

¿Es para ti?

Si haces reportes con más de 2 fuentes, dependes de archivos manuales o te duele la cabeza con cada cierre de mes… sí.

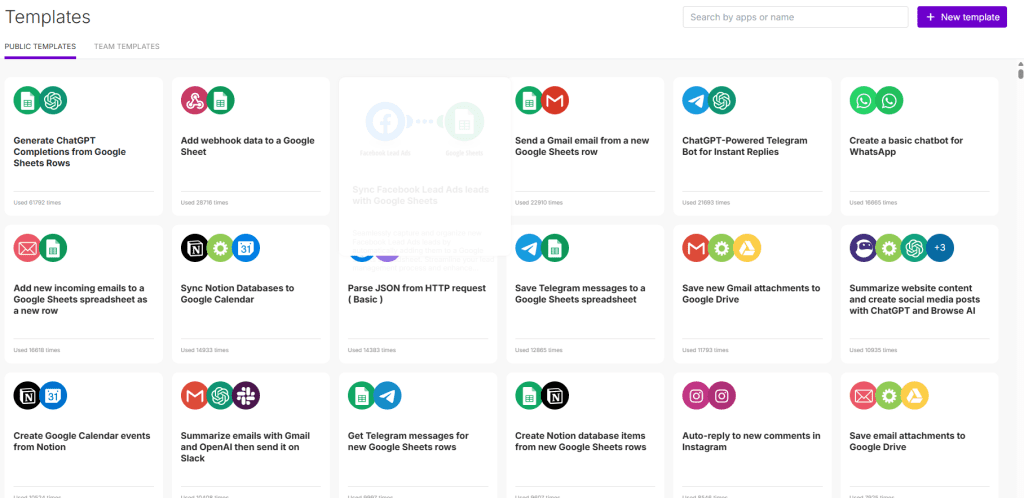

Y no hace falta ser Amazon. Hay soluciones low-code, modelos escalables y plantillas listas para usar.

Tener un Data Warehouse ya no es un lujo. Es supervivencia.

Primeros pasos: monta el tuyo sin volverte loco

¿Te ha convencido la idea de tener un Data Warehouse pero no sabes por dónde empezar?

Tranquilo, no necesitas ser ingeniero de datos ni montar un equipo de IT.

Aquí tienes una guía rápida para dar tus primeros pasos sin frustraciones:

- Define tus fuentes de datos: lista todo lo que esté en uso (desde el CRM hasta ese Excel compartido).

- Elige tu stack: Google BigQuery, Redshift, Snowflake… o algo más sencillo como PostgreSQL.

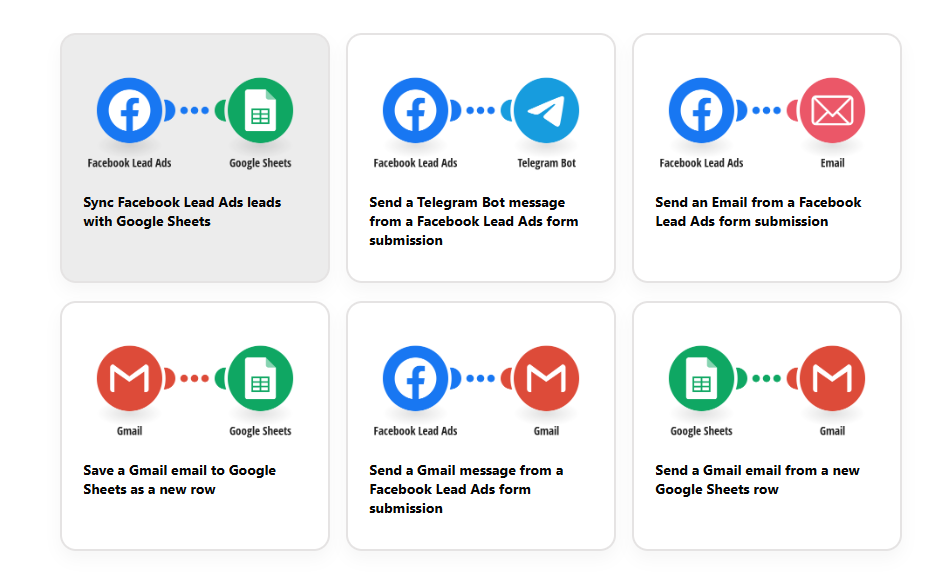

- Usa una ETL amigable: prueba con herramientas como Airbyte, Stitch o Supermetrics.

- Crea una capa semántica: que los usuarios no tengan que adivinar qué significa «funnel_stage».

- Conecta con tu BI favorito: Looker Studio, Power BI o Tableau. Lo importante es que entiendas lo que ves.

Y si quieres resultados rápidos: empieza pequeño, pero empieza.

Conclusión: controla tu caos

Tu negocio ya tiene datos.

Lo que te falta es orquestarlos.

Y para eso está el Data Warehouse.

Empieza hoy, toma el control y transforma tu forma de decidir.

No te falta información, te falta orquestarla.

Y para eso está el Data Warehouse.

«Cuando los datos hablan el mismo idioma, las decisiones suenan mejor.»

Haz que tu empresa deje de improvisar.

Toma el control de tu información y transforma el ruido en una sinfonía de resultados.

CTA: ¡Aprende a montar el tuyo paso a paso! Descarga mi guía gratuita y deja de sufrir con los informes.